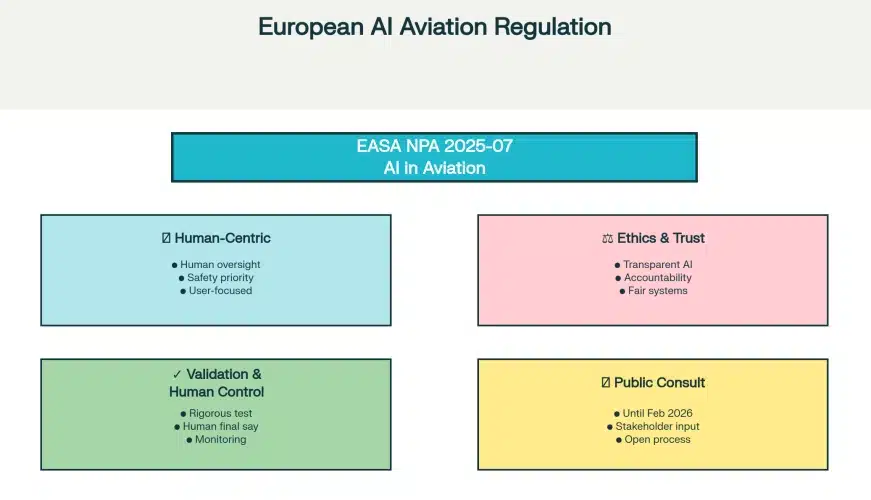

(Aeronoticias): Eduardo Gavilán, Editor, Sp.- ¿Te has preguntado quién o qué estará realmente al mando en los aviones del futuro? Mientras el debate público a menudo se pierde en la ciencia ficción y la narrativa de la industria tecnológica —centrada en el despliegue rápido y disruptivo de la IA—, la Agencia de Seguridad Aérea de la Unión Europea (EASA) ha presentado una visión radicalmente distinta. En un detallado borrador de normativa, emitido como respuesta a la Ley de IA de la UE (Reglamento (UE) 2024/1689), se establece un modelo de innovación responsable que sirve de contrapunto a la cultura del «muévete rápido y rompe cosas».

Lejos de abrir las puertas a una IA todopoderosa, este nuevo marco regulatorio revela un enfoque mucho más cauteloso, medido y centrado en el ser humano de lo que la mayoría imagina. A continuación, destilamos las 4 revelaciones más sorprendentes y contraintuitivas de esta nueva propuesta sobre la «confiabilidad de la IA» en la aviación.

Las 4 Revelaciones sobre la IA en la Aviación

1. Las IA más arriesgadas están (por ahora) prohibidas en la cabina

Contrariamente a los temores populares de una IA autónoma e impredecible tomando el control, la normativa de la EASA comienza por trazar una línea roja muy clara. Prohíbe explícitamente el uso de los tipos de inteligencia artificial de mayor riesgo en los sistemas de aviación, estableciendo un perímetro de seguridad desde el principio (sección DS.AI.010).

En concreto, la regulación excluye:

- Sistemas de IA que puedan causar directamente fatalidades o lesiones graves.

- Sistemas de IA con capacidad de aprendizaje en línea (es decir, aquellos que podrían cambiar su comportamiento por sí mismos durante un vuelo).

- Sistemas de IA de tipo lógico o híbrido cuyo fallo tenga cualquier consecuencia superior a «ningún efecto en la seguridad».

Este último punto es crucial. «Ningún efecto en la seguridad» es la clasificación más benigna en la regulación aeronáutica. Esto significa que si un tipo particular de IA avanzada tiene el potencial de causar incluso un problema de seguridad menor al fallar, su uso está actualmente fuera de los límites. Esta prohibición del aprendizaje en línea se deriva de un principio regulatorio fundamental: la previsibilidad. Un sistema que se modifica a sí mismo en pleno vuelo ya no es, por definición, el sistema que fue certificado originalmente como seguro, y por ello no tiene cabida en la aviación actual.

2. La IA será evaluada por su ética, no solo por su rendimiento

Uno de los aspectos más revolucionarios de esta normativa es que va mucho más allá de simplemente verificar si el código funciona. El documento exige una «evaluación basada en la ética» que se adentra en el impacto psicológico y social que el sistema podría tener sobre su usuario humano, ya sea un piloto o un controlador aéreo (sección DS.AI.140).

Para los sistemas de IA de Nivel 2 (colaboración humano-IA), esta evaluación debe identificar y mitigar riesgos tan sorprendentes como (sección AMC1 AI.140(b)):

- El riesgo de crear sesgos injustos en los datos o en los modelos entrenados.

- El riesgo de que el sistema cree apego emocional (Attachment) en el usuario.

- El riesgo de estimular un comportamiento adictivo (Addictive behaviour).

- El riesgo de manipular el comportamiento (Manipulating behaviour) del profesional a cargo.

Para enfatizar lo serio que se toman estos criterios, la propia normativa define formalmente qué entiende por «apego emocional» (sección DS.AI.020):

Attachment. Comportamiento asociado con la formación y la inversión en un vínculo significativo; búsqueda de una relación social de apoyo emocional con el sistema basado en IA.

Que un regulador de aviación, un campo dominado por la ingeniería y la física, se preocupe por la salud mental y el bienestar del «usuario final» es profundamente revelador. Demuestra una comprensión sofisticada de la interacción humano-máquina, reconociendo que la confianza no solo se basa en la fiabilidad técnica, sino también en una relación psicológica saludable y libre de manipulación.

3. El humano siempre conserva la responsabilidad (y las decisiones más difíciles)

El marco regulatorio deja muy claro que la IA es una herramienta al servicio del humano, y la jerarquía de mando es incuestionable. La normativa clasifica los sistemas en diferentes niveles, pero solo contempla la aplicación de los dos primeros: Nivel 1 (Aumento/Asistencia) y Nivel 2 (Cooperación/Colaboración) (sección AMC1 AI.110). En todos estos casos, la responsabilidad final recae inequívocamente en el usuario humano.

La delegación de autoridad se gestiona con extrema cautela. En los niveles 1A, 1B y 2A, el profesional humano conserva la «autoridad total». Solo en el nivel más alto permitido, el 2B (colaboración), se introduce el concepto de «autoridad parcial».

Más interesante aún es cómo la regulación define los límites de esa «autoridad parcial». Basándose en el paradigma SRK sobre la toma de decisiones humanas (sección GM3 AI.110), establece qué tipo de decisiones se pueden delegar y cuáles no:

- Basadas en habilidades (Skill-based): Tareas rutinarias y repetitivas. SÍ se pueden transferir a la IA.

- Basadas en reglas (Rule-based): Aplicar protocolos y procedimientos predefinidos. SÍ se pueden transferir a la IA.

- Basadas en conocimiento (Knowledge-based): Situaciones complejas, dinámicas o inciertas que requieren experiencia y juicio humano. NO se pueden transferir a la IA.

Esta distinción es fundamental. Que la EASA aplique un modelo de rendimiento humano de hace 40 años (Rasmussen, 1983) para definir los límites de la IA es una prueba poderosa de la tesis humanocéntrica del reglamento. Reconoce explícitamente los límites de la tecnología actual, reservando las decisiones más críticas —aquellas que requieren improvisación y una comprensión profunda del contexto— exclusivamente para el cerebro humano.

4. Cada IA debe operar dentro de un «sandbox» digital estrictamente definido

La percepción pública de la IA es a menudo la de una inteligencia general capaz de adaptarse a cualquier situación. La realidad en la aviación será todo lo contrario. La normativa introduce un enfoque de contención de múltiples capas.

En primer lugar, define el «Dominio Operacional» (OD), que es el «sandbox» o campo de juego para todo el sistema basado en IA. Pero la regulación va un paso más allá y crea una segunda capa de contención: el «Dominio Operacional de Diseño» (ODD), que define un sandbox aún más pequeño y específico para cada «constituyente de IA/ML» individual dentro del sistema (sección GM1 AI.150). Este enfoque de «muñeca rusa» de la seguridad garantiza que cada parte de la IA se mantenga bajo un estricto control.

El ODD de un componente de IA define con precisión milimétrica las condiciones exactas bajo las cuales se ha diseñado, entrenado y verificado que funciona de forma segura. Esto incluye, entre otros:

- Condiciones meteorológicas (rango de vientos, visibilidad, etc.).

- Condiciones geográficas (operación sobre mar, tierra, zonas montañosas).

- Restricciones de hora del día (día, noche, crepúsculo).

La regulación exige no solo definir este «sandbox», sino también analizar la «exposición a datos fuera del rango» (sección DS.AI.130(b)(6)) y crear sistemas capaces de detectar en tiempo real cuándo un componente de IA se encuentra fuera de su zona de confort (sección GM1 AI.130(b)(6)). En la práctica, esto significa que la IA en la aviación no será una inteligencia adaptable y generalista, sino un conjunto de herramientas altamente especializadas y confinadas, cuyo comportamiento es siempre predecible y, por lo tanto, seguro.

Conclusión: Un Futuro Cauteloso y Centrado en el Humano

Las cuatro revelaciones de esta propuesta normativa pintan un cuadro coherente: el enfoque de Europa hacia la IA en la aviación es pragmático, incremental y, sobre todo, profundamente humanocéntrico. La prioridad no es la innovación por sí misma, sino la «confiabilidad» y el mantenimiento de los niveles de seguridad existentes, que ya son extraordinariamente altos. Esta postura conservadora no es arbitraria; se fundamenta en la complejidad irreductible de la aviación, la importancia primordial de la confianza pública y las lecciones aprendidas de fallos de automatización pasados.

No veremos sistemas que aprenden sobre la marcha ni decisiones críticas delegadas a un algoritmo. En su lugar, veremos herramientas muy específicas, evaluadas ética y psicológicamente, que operan dentro de límites estrictos y siempre bajo la autoridad y responsabilidad de un profesional humano.

Fuente: aviaciondigital.com